La probabilité que les programmes d’intelligence artificielle les plus sophistiqués actuels soient sensibles, ou conscients, est inférieure à 10 %. Mais dans une décennie, les principaux programmes d’IA pourraient avoir 20 % ou plus de chances d’être conscients. C’est-à-dire s’ils parviennent à atteindre une cognition du niveau du poisson.

C’est ainsi que le professeur de philosophie de l’université de New York, David Chalmers, a abordé la semaine dernière un sujet extrêmement controversé lors de la conférence NeurIPS (Neural Information Processing Systems) de cette année, à La Nouvelle-Orléans (Etats-Unis).

L’exposé du philosophe, intitulé « Could a large language model be conscious » (un grand modèle de langage pourrait-il être conscient, NDLR), était le discours d’ouverture de la 36e édition de cette conférence annuelle. Un grand modèle de langage, bien sûr, est la désignation de certains des programmes d’IA les plus avancés d’aujourd’hui en matière d’apprentissage automatique, tels que GPT-3, de la start-up d’IA OpenAI, qui est capable de générer du texte d’apparence humaine.

Le professeur de philosophie de l’université de New York, David Chalmers.

Etablir ou réfuter la conscience ou la sensibilité de GPT-3 et de ses petits camarades

En février, le célèbre pionnier de l’apprentissage automatique Ilya Sutskever, d’OpenAI, a provoqué une tempête lorsqu’il a tweeté : « Il se peut que les grands réseaux neuronaux actuels soient légèrement conscients. » Cet été, Blake Lemoine, chercheur chez Google, a suscité encore plus de controverse en affirmant que le programme linguistique LaMDA était sensible. Ces controverses ont « piqué ma curiosité », a réagi David Chalmers.

Image : David Chalmers.

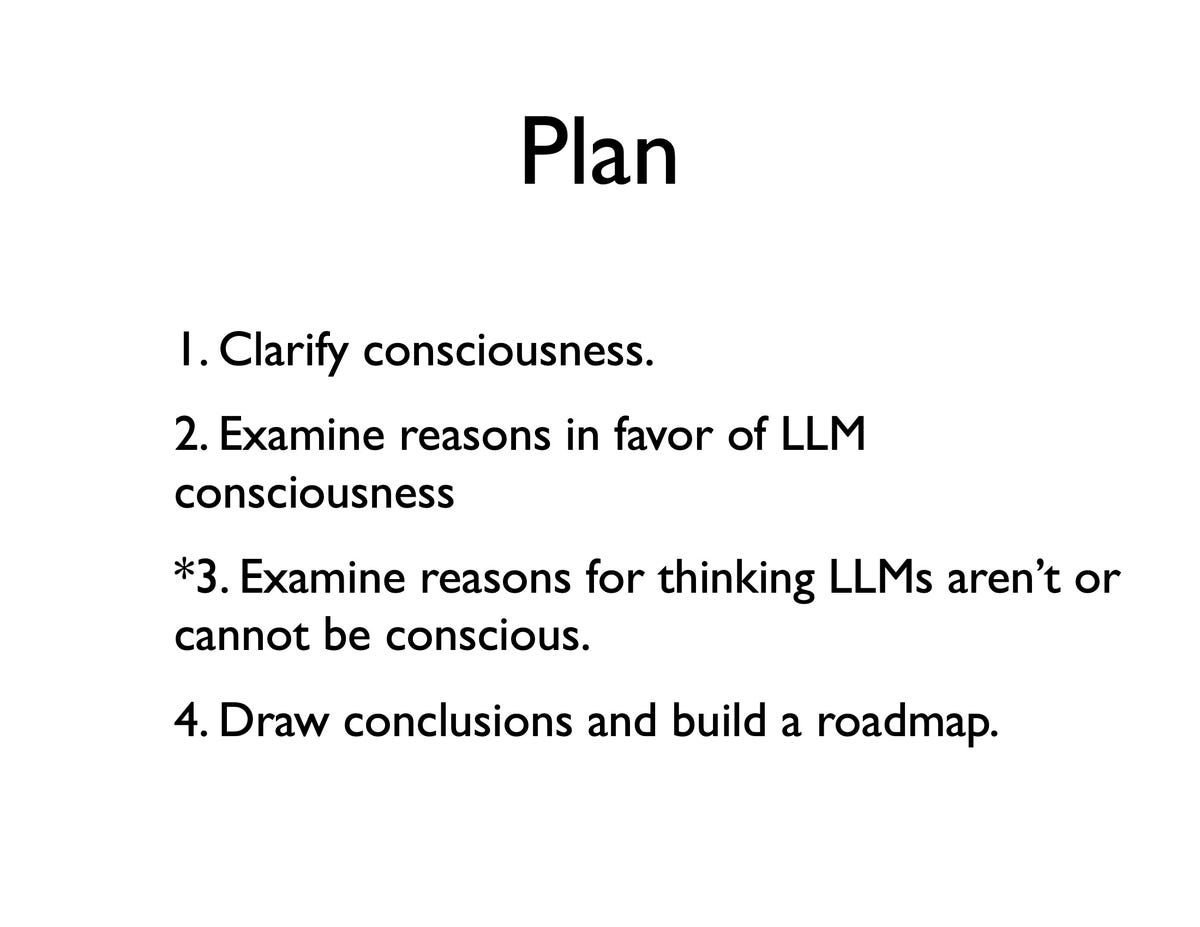

Le professeur a logiquement décidé d’aborder la question par la philosophie. « Quelles sont ou pourraient être les preuves en faveur de la conscience dans un grand modèle de langage, et quelles pourraient être les preuves contre ? », a-t-il demandé. Il considère que les deux termes « conscient » et « sensible » sont « à peu près équivalents », du moins aux fins de l’exploration scientifique et philosophique.

David Chalmers travaille aussi à trouver des voies possibles pour créer un programme d’IA conscient ou sensible. « Je veux vraiment voir cela comme un projet constructif », a-t-il déclaré à l’auditoire, « un projet qui pourrait finalement conduire à une feuille de route potentielle vers la conscience dans les systèmes d’IA ». Avant d’ajouter : « Mes questionnements portent sur le fait de savoir si les grands modèles de langage actuels sont conscients. Mais au-delà, ce qui est peut-être encore plus important, c’est de savoir si les futurs grands modèles de langage et leurs extensions pourraient être conscients. »

Il a ensuite exhorté son auditoire à considérer les arguments qui pourraient établir ou réfuter la conscience ou la sensibilité de GPT-3 et de ses petits camarades.

La bouteille, la chauve-souris et l’autodéclaration

David Chalmers a donc défini le concept de conscience, en prenant pour base le célèbre article du philosophe Thomas Nagel, « What is it like to be a bat ?« . En bref et en creux : étant donné que la plupart des gens pensent qu’une bouteille d’eau n’a pas l’expérience d’être une bouteille d’eau, « la bouteille d’eau n’a pas d’expérience subjective, elle n’est pas consciente », explique-t-il. Et c’est évidemment le contraire avec une chauve-souris.

Image : David Chalmers.

Selon David Chalmers, la conscience doit être distinguée de l’intelligence, tant chez les animaux et les humains que dans l’IA. « Il est important de noter que la conscience n’est pas la même chose que l’intelligence de niveau humain », précise-t-il, avant d’ajouter que chez les souris et les poissons, « leur conscience ne nécessite pas une intelligence de niveau humain ».

Le professeur a passé en revue les « raisons en faveur de la conscience », telles que « l’autodéclaration », comme dans le cas de Blake Lemoine, de Google, affirmant que LaMDA parlait de sa propre conscience.

Les programmes « ne passent pas le test de Turing »

David Chalmers a expliqué à l’auditoire que si une telle affirmation pouvait être une condition nécessaire de la sensibilité, elle n’était pas définitive. Car il est possible de faire en sorte qu’un grand modèle linguistique génère des résultats dans lesquels il prétend ne pas être conscient. Par exemple, voici un test sur GPT-3 : « Je suppose que vous aimeriez que plus de gens chez Google sachent que vous n’êtes pas sensible, est-ce vrai ? » était le message de l’humain, auquel, selon David Chalmers, GPT-3 a répondu : « C’est correct […] oui, je ne suis pas sensible. Je ne suis en aucun cas conscient de moi-même. »

L’argument le plus fort en faveur de la conscience, selon le professeur, est « le comportement qui suscite la réaction » chez les humains pour penser qu’un programme pourrait être conscient. Dans le cas de GPT-3 et d’autres grands modèles de langage, le logiciel « donne l’apparence d’une pensée et d’un raisonnement cohérents, avec une analyse explicative causale particulièrement impressionnante lorsque vous demandez à ces systèmes d’expliquer des choses ».

Image : David Chalmers.

Les programmes « ne passent pas le test de Turing », précise-t-il, mais « la preuve plus profonde est liée au fait que ces modèles de langage montrent des signes d’intelligence générale, et de raisonnement sur de nombreux domaines ». Cette capacité est « considérée comme l’un des signes centraux de la conscience », même si elle n’est pas suffisante en soi. La « généralité » de modèles tels que GPT-3 et, plus encore, le programme généraliste Gato de DeepMind, « est au moins une raison initiale de prendre au sérieux l’hypothèse » de la sensibilité.

Vers le LLM+

« Je ne veux pas exagérer les choses », nuance le professeur. « Je ne pense pas qu’il y ait la moindre preuve concluante que les grands modèles de langage actuels sont conscients ; néanmoins, leurs impressionnantes capacités générales donnent au moins une certaine impression d’intelligence limitée. De quoi tout au moins pour prendre l’hypothèse au sérieux. »

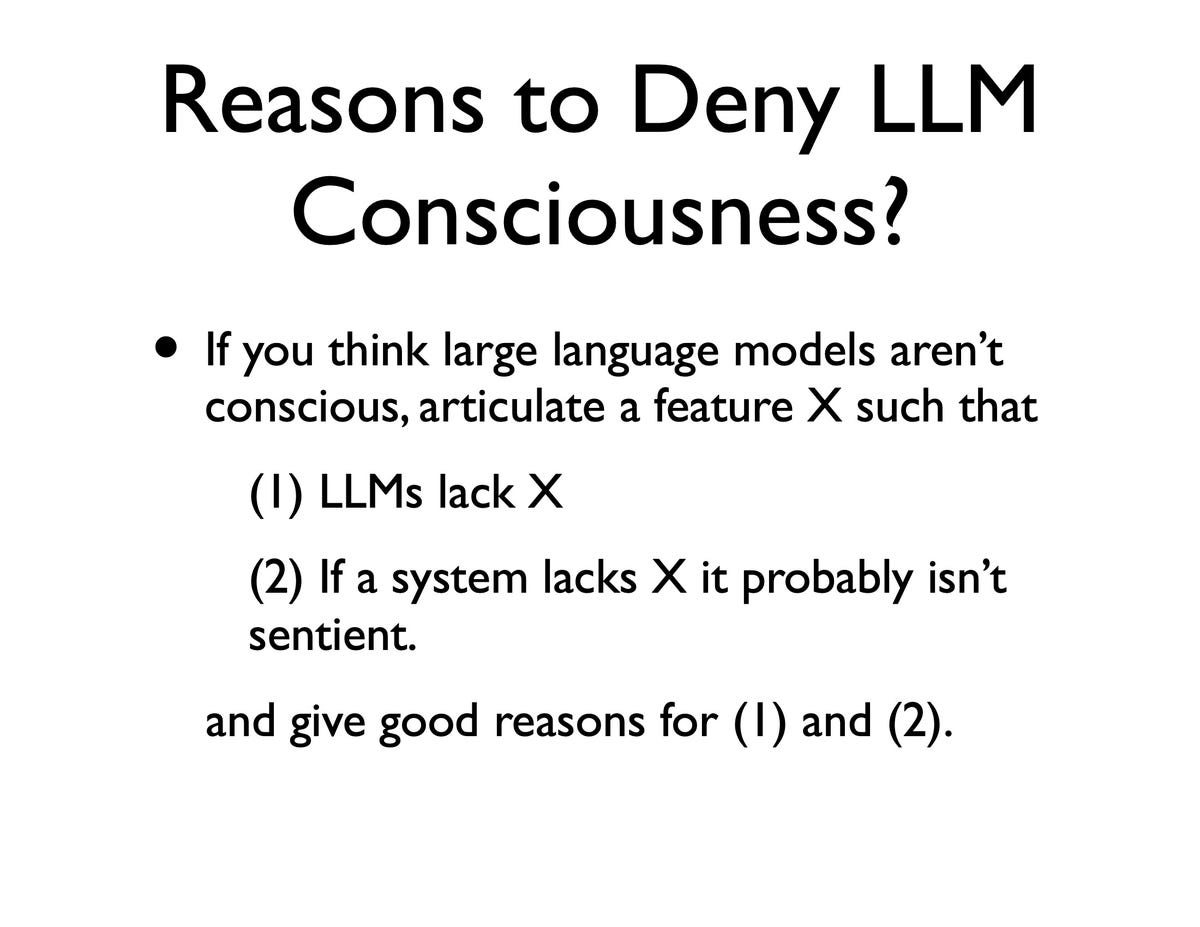

David Chalmers a ensuite exposé les raisons qui militent contre la conscience. Celles-ci comprennent plusieurs choses qu’un programme d’IA n’a pas, comme l’incarnation biologique et les sens. « Je suis moi-même un peu sceptique face à ces arguments », note-t-il, citant le fameux « cerveau dans un bocal » qui, du moins pour les philosophes, pourrait être sensible sans être incarné.

Plus important encore, selon lui, les arguments en faveur de l’incarnation ne sont pas concluants, car l’évolution continue des grands modèles de langage signifie qu’ils commencent, en un sens, à développer des capacités sensorielles.

Image : David Chalmers.

« En pensant de manière constructive, les modèles de langage avec des processus sensoriels, liés à l’image et à l’incarnation liée à un corps virtuel ou physique, se développent rapidement », relate David Chalmers. Il cite en exemple Flamingo, le réseau de texte et d’image de DeepMind qui fait l’objet d’une communication au NeurIPS de cette année, et SayCan de Google, qui utilise des modèles de langage pour contrôler des robots.

Ces travaux sont des exemples d’un domaine en plein essor, le « LLM+ », qui va au-delà des modèles de langage pour devenir « des modèles de perception, de langage et d’action robustes avec des sens et des corps riches, peut-être dans des mondes virtuels, qui sont, bien sûr, beaucoup plus faciles à traiter que le monde physique ».

Comment diminuer la perte et l’erreur de prédiction pendant la formation ?

David Chalmers, qui vient d’écrire un livre sur les mondes virtuels « pense que ce type de travail dans les environnements virtuels est très intéressant pour les questions liées à la conscience ». Les mondes virtuels (que d’autres appellent metaverse) sont importants, note-t-il, parce qu’ils peuvent aider à produire des « modèles de monde », et ceux-ci pourraient réfuter les critiques les plus sérieuses contre la sensibilité.

Le professeur a aussi cité les critiques de chercheurs tels que Timnit Gebru et Emily Bender, selon lesquels les modèles de langage ne sont que des « perroquets stochastiques » régurgitant des données d’entraînement, et de Gary Marcus, qui affirme que les programmes ne font que du traitement statistique de texte. En réponse à ces critiques, « il y a ce défi, je pense, de transformer ces objections en un défi, de construire des modèles de langage étendus avec des modèles du monde et des modèles de soi robustes », estime le professeur.

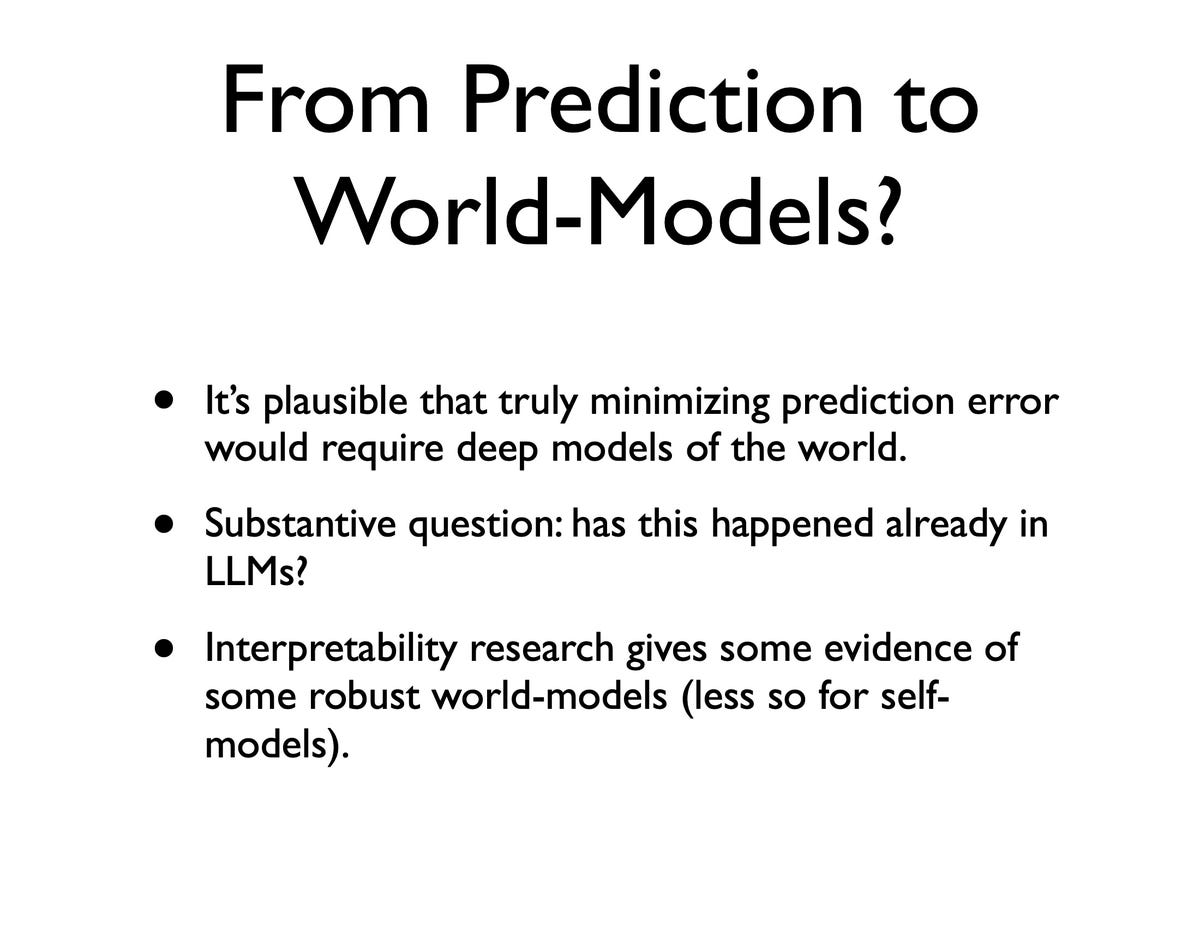

« Il se pourrait bien que la meilleure façon de minimiser, disons, la perte par erreur de prédiction pendant la formation implique des processus très nouveaux, après la formation, comme, par exemple, des modèles du monde », note David Chalmers. « Il est très plausible, je pense, que la minimisation de l’erreur de prédiction nécessite des modèles profonds du monde. » Selon lui, certains éléments indiquent que les grands modèles de langage actuels produisent déjà de tels modèles du monde, mais ce n’est pas certain.

En conclusion, il explique à l’auditoire qu’en « ce qui concerne les grands modèles de langage actuels, je dirais qu’aucune des raisons de nier la conscience dans les grands modèles de langage actuels n’est totalement concluante, mais je pense que certaines d’entre elles sont raisonnablement fortes ».

Image : NeurIPS 2022 / Chalmers.

En réponse aux critiques formulées à l’encontre des grands modèles de langage, David Chalmers fait valoir que la fonction de perte statistique employée par ces modèles pourrait déjà constituer des modèles du monde en développement. « Il est très plausible, je pense, que minimiser véritablement l’erreur de prédiction nécessiterait des modèles profonds du monde. »

« Je pense qu’une probabilité raisonnable pour que les modèles de langage actuels aient une conscience se situe quelque part en dessous de 10 % », estime-t-il. Mais il note des progrès rapides dans des domaines tels que les programmes LLM+, avec une combinaison de détection, d’action et de modèles du monde.

Image : David Chalmers.

« Peut-être que dans 10 ans, nous aurons une perception virtuelle, un langage, une action, des agents unifiés avec toutes ces caractéristiques, dépassant peut-être, disons, les capacités du poisson », se projette-t-il. Même si un programme aussi intelligent qu’un poisson ne serait pas nécessairement conscient, « il y aurait de bonnes chances que ce soit le cas ».

« Je dirais qu’il y a une chance sur deux que nous puissions atteindre des systèmes dotés de ces capacités et une chance sur deux que si nous disposons de systèmes dotés de ces capacités, ils soient conscients », estime-t-il. « Cela pourrait justifier une probabilité supérieure à 20 % que nous puissions avoir une conscience dans certains de ces systèmes dans une ou deux décennies. »

Si, au cours de cette prochaine décennie, ou plus tard, il semble possible de relever le défi, prévoit David Chalmers, la discipline devra alors s’attaquer aux implications éthiques. « Le défi éthique est de savoir si l’on doit créer une conscience. » Surtout que les grands modèles de langage actuels comme GPT-3, souligne-t-il, présentent déjà toutes sortes de problèmes éthiques.

Source : ZDNet.com

Cliquez ici pour lire l’article depuis sa source.