Jensen Huang, PDG de Nvidia, a présenté la première itération de Spectrum-X, la puce Spectrum-4, avec cent milliards de transistors dans une matrice de 90 millimètres par 90 millimètres. Nvidia

>

Le PDG de Nvidia, Jensen Huang, lors de la conférence d’ouverture du salon Computex, lundi à Taipei (Taïwan), a dévoilé une série de nouveaux produits, dont un nouveau type de commutateur Ethernet destiné à transporter de gros volumes de données pour des tâches d’intelligence artificielle.

« Comment introduire un nouvel Ethernet, qui soit rétrocompatible avec tout ce qui existe, pour transformer chaque centre de données en un centre de données d’intelligence artificielle générative ? », a demandé M. Huang dans sa keynote. « Pour la première fois, nous apportons les capacités de l’informatique haute performance sur le marché de l’Ethernet », a déclaré M. Huang.

Selon Nvidia, le Spectrum-X, nom donné à cette famille de connectivité Ethernet, est « le premier Ethernet haute performance au monde pour l’IA ». L’une des principales caractéristiques de cette technologie est qu’elle « ne laisse pas tomber les paquets », a déclaré Gilad Shainer, vice-président senior des réseaux.

Spectrum-4, la première itération de Spectrum-X

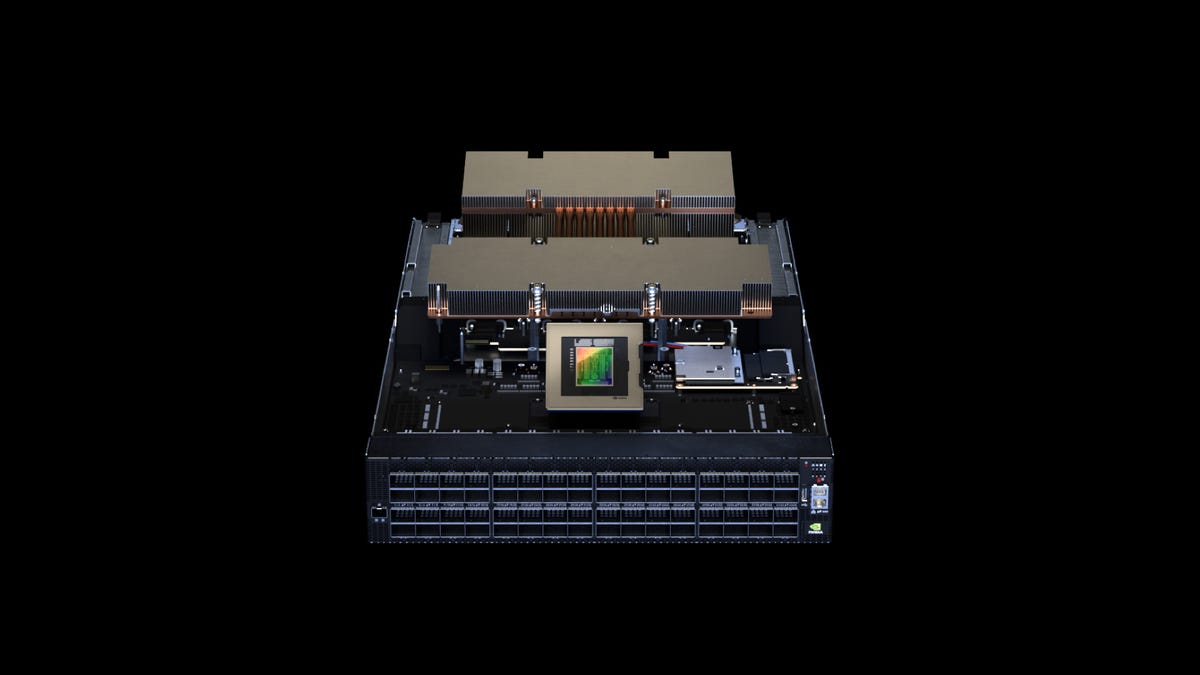

La première itération de Spectrum-X est Spectrum-4, a déclaré Nvidia, qui l’a qualifiée de « premier commutateur Ethernet de 51 To/sec au monde conçu spécifiquement pour les réseaux d’intelligence artificielle ». Le commutateur fonctionne en conjonction avec l’unité de traitement des données BlueField de Nvidia, ou DPU, des puces qui gèrent la recherche et la mise en file d’attente des données, et les émetteurs-récepteurs à fibre optique de Nvidia. Le commutateur peut acheminer 128 ports de 400 gigabits Ethernet, ou 64 ports de 800 gigabits, d’un bout à l’autre du réseau, indique la société.

M. Huang a présenté sur scène la puce argentée du commutateur Ethernet Spectrum-4, en précisant qu’elle était « gigantesque », composée de cent milliards de transistors sur une puce de 90 millimètres par 90 millimètres construite avec la technologie de traitement « 4N » de Taiwan Semiconductor Manufacturing. La pièce fonctionne à 500 watts, a déclaré M. Huang.

« Pour la première fois, nous apportons les capacités de calcul à haute performance sur le marché de l’Ethernet », a déclaré M. Huang. Nvidia

Spectrum-4 est le premier d’une ligne de puces Spectrum-X qui constituent un nouveau type d’Ethernet conçu pour fournir une transmission de paquets sans perte pour les charges de travail de l’intelligence artificielle. Nvidia

La famille Spectrum-X est conçue pour répondre à la bifurcation des centres de données dans deux directions. La première est ce qu’il appelle les « usines d’IA », des installations qui coûtent des centaines de millions d’euros pour les GPU les plus puissants, basés sur NVLink et Infiniband de Nvidia, utilisés pour l’entraînement à l’IA. L’autre centre de données est le cloud d’IA (multi-locataire, basé sur Ethernet), qui se concentre sur la fourniture de prédictions aux consommateurs d’IA, qui seront desservis par le Spectrum-X.

Le Spectrum-X, a déclaré le vice-président Shainer, est capable de « répartir le trafic sur le réseau de la meilleure façon possible », en utilisant « un nouveau mécanisme de contrôle de la congestion », qui évite l’empilement de paquets qui peut se produire dans la mémoire tampon des routeurs du réseau. « Nous utilisons une nouvelle télémétrie pour comprendre les temps de latence à travers le réseau afin d’identifier les points chauds, afin de maintenir le réseau exempt de congestion ». Nvidia a déclaré que « les principaux hyperscalers du monde adoptent NVIDIA Spectrum-X ».

A titre de démonstration, Nvidia construit un ordinateur test dans ses bureaux en Israël, appelé Israel-1, un « supercalculateur génératif d’IA », utilisant des serveurs Dell PowerEdge XE9680 composés de GPU H100 faisant tourner les données à travers les commutateurs Spectrum-4.

DGX, un ordinateur pour l’IA

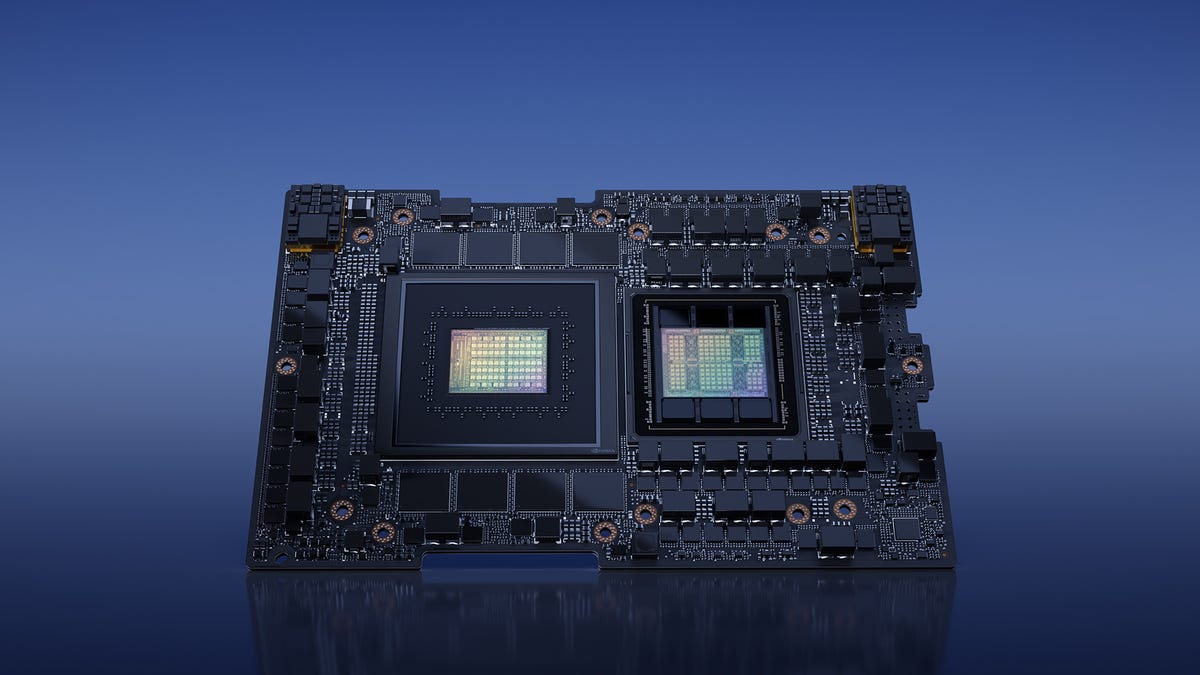

En plus de cette nouvelle technologie Ethernet, Huang a présenté un nouveau modèle de la série « DGX » d’ordinateurs pour l’IA, le DGX GH200, que l’entreprise décrit comme « une nouvelle classe de supercalculateur d’IA à grande mémoire pour les modèles d’IA génératifs géants ».

L’IA générative fait référence à des programmes qui produisent plus qu’un score, parfois sous forme de texte, parfois sous forme d’images, ou d’autres artefacts, comme, par exemple, le bot ChatGPT d’OpenAI. Le GH200 est le premier système à être livré avec ce que la société appelle sa « super-puce », la carte Grace Hopper, qui contient sur un seul circuit imprimé un GPU Hopper et le processeur Grace, un processeur basé sur le jeu d’instructions ARM destiné à concurrencer les processeurs x86 d’Intel et d’Advanced Micro Devices (AMD).

La « super-puce » Grace Hopper de Nvidia, une carte contenant le processeur Grace (à gauche) et le GPU Hopper, est désormais en pleine production, a déclaré l’entreprise. Nvidia

La première itération de Grace Hopper, le GH200, est « en pleine production », a déclaré Huang. Nvidia a déclaré que « les hyperscalers mondiaux et les centres de supercalcul en Europe et aux États-Unis sont parmi les clients qui auront accès aux systèmes alimentés par le GH200 ».

Selon Nvidia, le DGX GH200 combine 256 superpuces pour atteindre une puissance combinée de 1 exaflops – dix à la puissance 18, soit un milliard de milliards d’opérations en virgule flottante par seconde – en utilisant 144 téraoctets de mémoire partagée. Selon Nvidia, l’ordinateur est 500 fois plus rapide que la machine DGX A100 originale sortie en 2020.

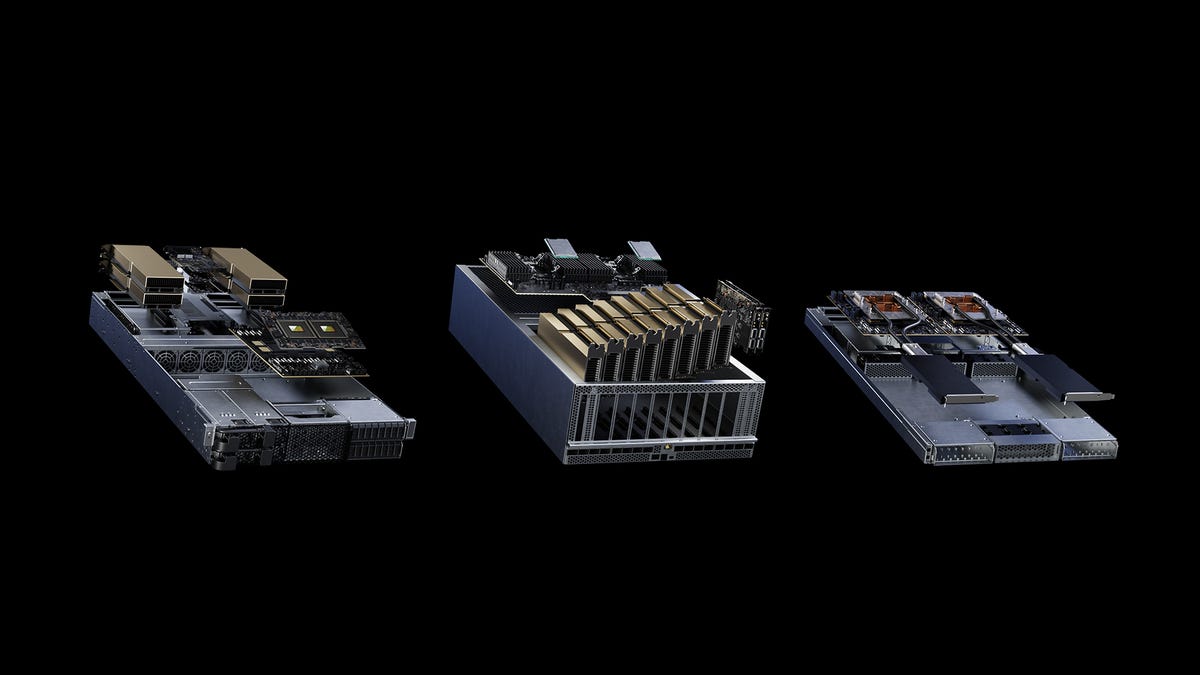

MGX, une architecture de référence pour créer des variantes de serveurs

La conférence a également dévoilé MGX, une architecture de référence permettant aux fabricants de systèmes de créer des variantes de serveurs de plus de 100 unités. Les premiers partenaires à utiliser cette spécification sont ASRock Rack, ASUS, GIGABYTE, Pegatron, QCT et Supermicro. QCT et Supermicro seront les premiers à commercialiser des systèmes en août, a déclaré Nvidia.

MGX est une architecture de référence permettant aux fabricants de systèmes informatiques de créer rapidement et à moindre coût plus de 100 variantes de serveurs utilisant des puces Nvidia. QCT et Supermicro seront les premiers à commercialiser des systèmes, en août, a déclaré Nvidia. Nvidia

Source : « ZDNet.com »

Cliquez ici pour lire l’article depuis sa source.